Trong thời đại mà trí tuệ nhân tạo (AI) đang trở thành động lực chính cho đổi mới và tạo ra lợi thế cạnh tranh, việc sở hữu một hạ tầng AI mạnh mẽ là điều thiết yếu đối với các doanh nghiệp đang đầu tư cho AI. Nó được xem như một Nhà máy AI (AI Factory), nơi các dữ liệu được đưa vào để tạo ra các sản phẩm kinh doanh có giá trị . Bên cạnh các giải pháp thuê dịch vụ đám mây, hạ tầng AI sở hữu riêng, có thể đặt ngay bên trong doanh nghiệp đang cho thấy là một lựa chọn mang tính hiệu quả cao và đem lại lợi ích lâu dài.

Lợi ích của hạ tầng AI sở hữu riêng

1. Kiểm Soát Hoàn Toàn Dữ Liệu

Dữ liệu là tài sản quý giá của doanh nghiệp, đặc biệt trong các ngành như tài chính, y tế, sản xuất và chính phủ. Việc lưu trữ và xử lý dữ liệu AI tại chỗ giúp doanh nghiệp đảm bảo tính bảo mật, quyền riêng tư và tuân thủ các quy định pháp lý mà không phải lo lắng về nguy cơ rò rỉ dữ liệu khi sử dụng dịch vụ đám mây.

2. Độ Trễ Thấp, Xử Lý Nhanh Chóng

Với hạ tầng AI Factory, doanh nghiệp có thể xử lý dữ liệu tại chỗ với độ trễ thấp, giúp cải thiện tốc độ phản hồi của các ứng dụng AI theo thời gian thực. Điều này đặc biệt quan trọng đối với các hệ thống yêu cầu tính tức thời cao như phân tích video, giám sát an ninh, tự động hóa nhà máy hay xe tự hành.

3. Tối Ưu Hóa Hiệu Suất Và Chi Phí

Dù chi phí đầu tư ban đầu cho hạ tầng AI Factory có thể cao, nhưng về lâu dài, doanh nghiệp có thể tiết kiệm được chi phí vận hành so với việc sử dụng dịch vụ đám mây, đặc biệt khi khối lượng dữ liệu lớn và nhu cầu tính toán cao. Hơn nữa, doanh nghiệp có thể chủ động nâng cấp phần cứng và tối ưu hóa tài nguyên theo nhu cầu thực tế.

4. Độ Tin Cậy Cao, Giảm Phụ Thuộc Vào Nhà Cung Cấp Dịch Vụ

Việc triển khai AI Factory giúp doanh nghiệp giảm sự phụ thuộc vào các nhà cung cấp dịch vụ đám mây, tránh các rủi ro về gián đoạn dịch vụ, thay đổi chính sách giá cả hay giới hạn băng thông. Điều này đặc biệt quan trọng đối với các doanh nghiệp hoạt động trong môi trường yêu cầu độ ổn định cao.

5. Tùy Chỉnh Và Linh Hoạt

Với hạ tầng AI Factory, doanh nghiệp có thể dễ dàng tùy chỉnh và tối ưu hóa hệ thống theo yêu cầu cụ thể của mình. Từ việc lựa chọn phần cứng phù hợp đến thiết lập các mô hình AI chuyên biệt, tất cả đều có thể được điều chỉnh để đáp ứng tốt nhất nhu cầu kinh doanh.

Một hệ thống AI hoàn chỉnh bao gồm những gì?

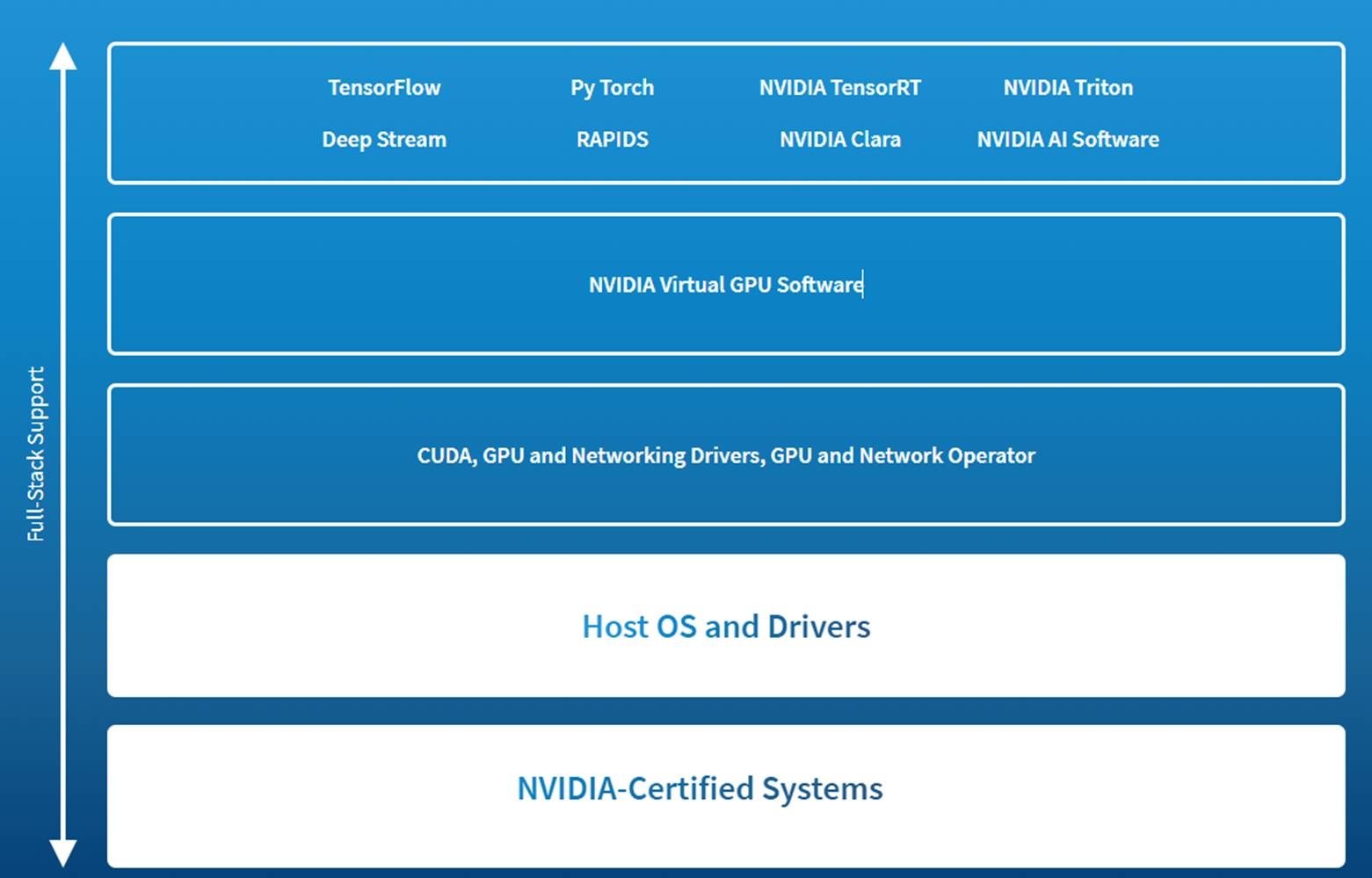

Một hệ thống AI hoàn chỉnh cần các thành phần khác nhau, từ phần cứng vật lý bên dưới cho đến các thành phần phần mềm (software stack) bên trên.

Để hệ thống là một “nhà máy AI” cung cấp khả năng đảm nhiệm các dự án AI từ đầu đến cuối một cách hiệu quả, các thành phần bên trong cần được lựa chọn và xây dựng phù hợp. Đối với phần cứng, đó là các hệ thống được chứng nhận là phù hợp với các GPU hiệu suất cao của NVIDIA.

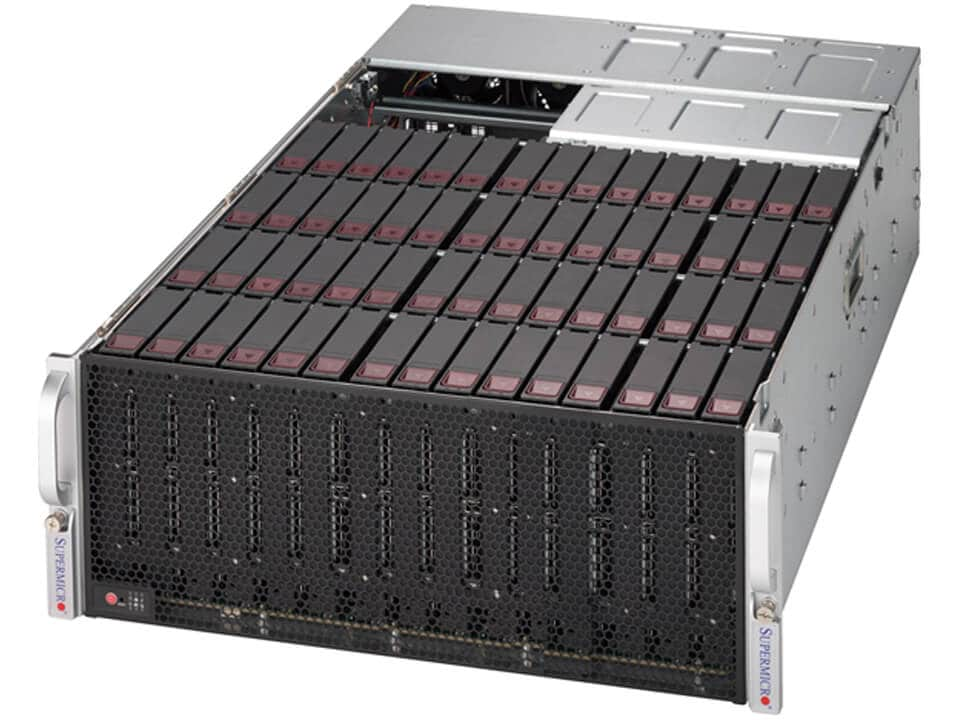

1. Máy chủ GPU chuyên dụng

Đây là nền tảng cốt lõi của hạ tầng AI, cung cấp sức mạnh tính toán và lưu trữ cần thiết. Máy chủ cần có khả năng mở rộng cao, hỗ trợ nhiều bộ xử lý và bộ nhớ để xử lý các tác vụ AI phức tạp.

Đây là nền tảng cốt lõi của hạ tầng AI, cung cấp sức mạnh tính toán và lưu trữ cần thiết. Máy chủ cần có khả năng mở rộng cao, hỗ trợ nhiều bộ xử lý và bộ nhớ để xử lý các tác vụ AI phức tạp.

Hiện tại, các GPU Server được thiết kế với dạng rackmount từ 1-4U giúp tối ưu không gian, mật độ lắp đặt multi-GPU từ 1-10 GPUs, và có khả năng làm mát, tản nhiệt rất tốt cho các GPU hiệu suất cao.

Hiện tại, các GPU Server được thiết kế với dạng rackmount từ 1-4U giúp tối ưu không gian, mật độ lắp đặt multi-GPU từ 1-10 GPUs, và có khả năng làm mát, tản nhiệt rất tốt cho các GPU hiệu suất cao.

Các thương hiệu máy chủ GPU được Nhất Tiến Chung lựa chọn đều là các đối tác tin cậy của NVIDIA và các hệ thống của họ được chứng nhận là phù hợp và tối ưu cho các ứng dụng của AI Training và Inference, tìm hiểu chuyên sâu tại đây:

Máy chủ GPU Server AI Training và Inference của Supermicro

Máy chủ GPU Server AI Training và Inference của Supermicro Máy chủ GPU Server AI Training và Inference của ASUS

Máy chủ GPU Server AI Training và Inference của ASUS Máy chủ GPU Server AI Training và Inference của Dell

Máy chủ GPU Server AI Training và Inference của Dell Máy chủ GPU Server AI Training và Inference của HPE

Máy chủ GPU Server AI Training và Inference của HPE

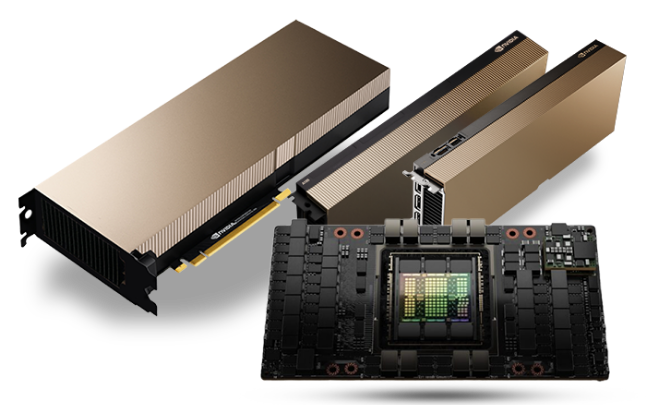

2. Bộ xử lý đồ họa (GPU)

GPU là thành phần không thể thiếu cho các tác vụ học sâu (deep learning), vì chúng có khả năng xử lý song song các phép tính ma trận lớn.

GPU là thành phần không thể thiếu cho các tác vụ học sâu (deep learning), vì chúng có khả năng xử lý song song các phép tính ma trận lớn.

Lựa chọn các GPU phù hợp với nhu cầu tính toán, từ NVIDIA H200 và H100 cho các tác vụ đào tạo mô hình lớn, phân tích dữ liệu, cho đến các GPU L40s, L40 và L4 cho suy luận. Hãy điểm qua các GPU trên để lựa chọn được loại GPU phù hợp cho hạ tầng AI của bạn.

2.1. NVIDIA H200 80GB Tensor Core GPU

NVIDIA H200 Tensor Core GPU mang đến bước đột phá trong hiệu suất và khả năng xử lý bộ nhớ, giúp tăng tốc các ứng dụng AI tổng quát (Generative AI) và điện toán hiệu suất cao (HPC).

Dựa trên kiến trúc NVIDIA Hopper™, H200 là GPU đầu tiên được trang bị bộ nhớ HBM3e 141GB với băng thông lên đến 4.8TB/s—gần gấp đôi dung lượng so với H100 và tăng 1.4 lần tốc độ truy xuất dữ liệu. Nhờ bộ nhớ lớn hơn và nhanh hơn, H200 giúp tăng tốc các mô hình AI, đặc biệt là mô hình ngôn ngữ lớn (LLM), đồng thời nâng cao hiệu suất điện toán khoa học với hiệu suất năng lượng tối ưu và chi phí vận hành thấp hơn.

H200 mang lại hiệu suất gấp đôi so với H100 khi xử lý các mô hình ngôn ngữ lớn như Llama2 70B, giúp rút ngắn thời gian phản hồi và tối ưu hóa tổng chi phí sở hữu (TCO) khi triển khai trên quy mô lớn.

NVIDIA H200 NVL là lựa chọn lý tưởng cho các hệ thống máy chủ doanh nghiệp yêu cầu hiệu suất cao với thiết kế tiết kiệm điện và làm mát bằng không khí. H200 NVL hỗ trợ kết nối tối đa 4 GPU qua NVIDIA NVLink™, tăng 1.5 lần dung lượng bộ nhớ và cải thiện hiệu suất inference LLM lên đến 1.7 lần so với H100 NVL. Các ứng dụng HPC cũng có thể đạt hiệu suất cao hơn 1.3 lần.

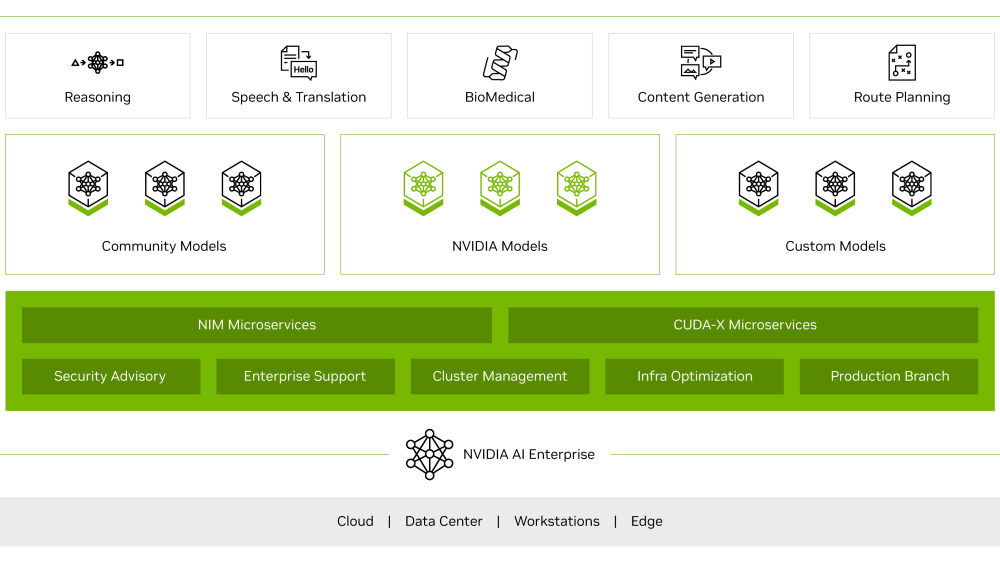

H200 NVL đi kèm với gói phần mềm NVIDIA AI Enterprise trong 5 năm, giúp đơn giản hóa việc triển khai và phát triển AI ở cấp độ doanh nghiệp.

→ Chi tiết về thông số kỹ thuật của GPU NVIDIA H200 xem tại đây.

2.2. NVIDIA L40S 48GB GPU

NVIDIA L40S GPU là GPU đa năng mạnh mẽ nhất cho trung tâm dữ liệu, mang lại khả năng tăng tốc toàn diện cho các ứng dụng hỗ trợ AI thế hệ mới—từ AI tạo sinh, suy luận LLM, đào tạo và tinh chỉnh mô hình nhỏ đến đồ họa 3D, dựng hình và ứng dụng video.

NVIDIA L40S GPU là GPU đa năng mạnh mẽ nhất cho trung tâm dữ liệu, mang lại khả năng tăng tốc toàn diện cho các ứng dụng hỗ trợ AI thế hệ mới—từ AI tạo sinh, suy luận LLM, đào tạo và tinh chỉnh mô hình nhỏ đến đồ họa 3D, dựng hình và ứng dụng video.

GPU L40S được tối ưu hóa cho hoạt động trung tâm dữ liệu doanh nghiệp 24/7 và được NVIDIA thiết kế, chế tạo, thử nghiệm và hỗ trợ để đảm bảo hiệu suất, độ bền và thời gian hoạt động tối đa.

GPU L40S đáp ứng các tiêu chuẩn trung tâm dữ liệu mới nhất, sẵn sàng cho Hệ thống xây dựng thiết bị mạng (NEBS) Cấp 3 và có tính năng khởi động an toàn với công nghệ gốc tin cậy, cung cấp thêm một lớp bảo mật cho trung tâm dữ liệu.

→ Chi tiết về thông số kỹ thuật của GPU NVIDIA L40s xem tại đây.

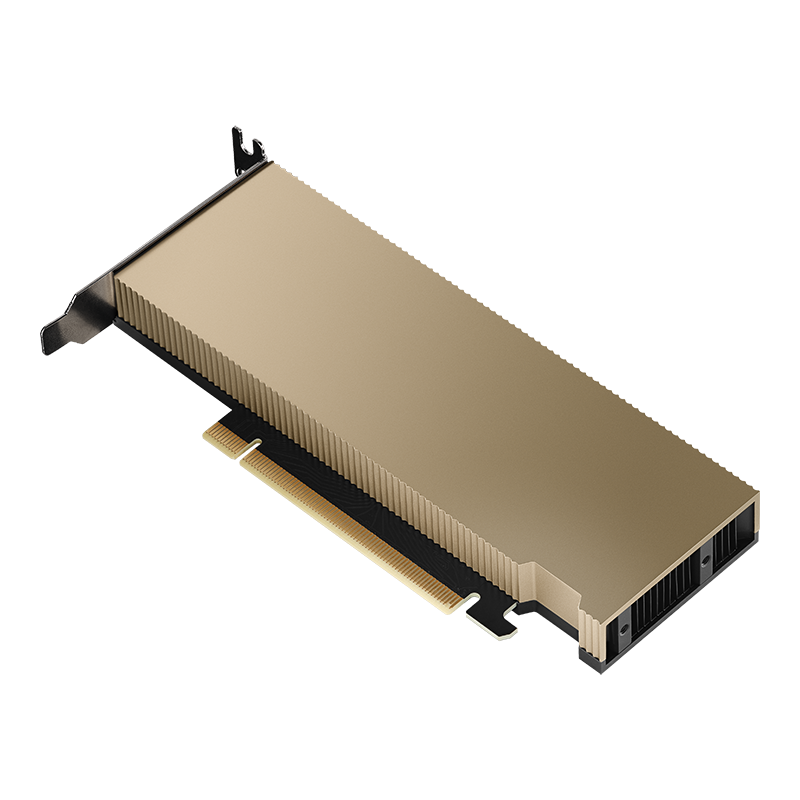

2.3. NVIDIA L40 48GB GPU

NVIDIA® L40 GPU mang lại hiệu suất điện toán hình ảnh chưa từng có cho trung tâm dữ liệu, cung cấp đồ họa, tính toán và khả năng AI thế hệ tiếp theo. Được xây dựng trên kiến trúc NVIDIA Ada Lovelace mang tính cách mạng, NVIDIA L40 khai thác sức mạnh của RT, Tensor và CUDA cores thế hệ mới nhất để mang lại hiệu suất trực quan hóa và tính toán đột phá cho các khối lượng công việc trung tâm dữ liệu đòi hỏi khắt khe nhất.

Được thiết kế cho hoạt động trung tâm dữ liệu doanh nghiệp 24×7 với phần cứng và linh kiện tiết kiệm điện năng, NVIDIA L40 được tối ưu hóa để triển khai ở quy mô lớn và mang lại hiệu suất tối đa cho nhiều khối lượng công việc trung tâm dữ liệu đa dạng.

L40 bao gồm khởi động an toàn với công nghệ gốc tin cậy cung cấp thêm một lớp bảo mật và tuân thủ NEBS Cấp 3 để đáp ứng các tiêu chuẩn trung tâm dữ liệu mới nhất.

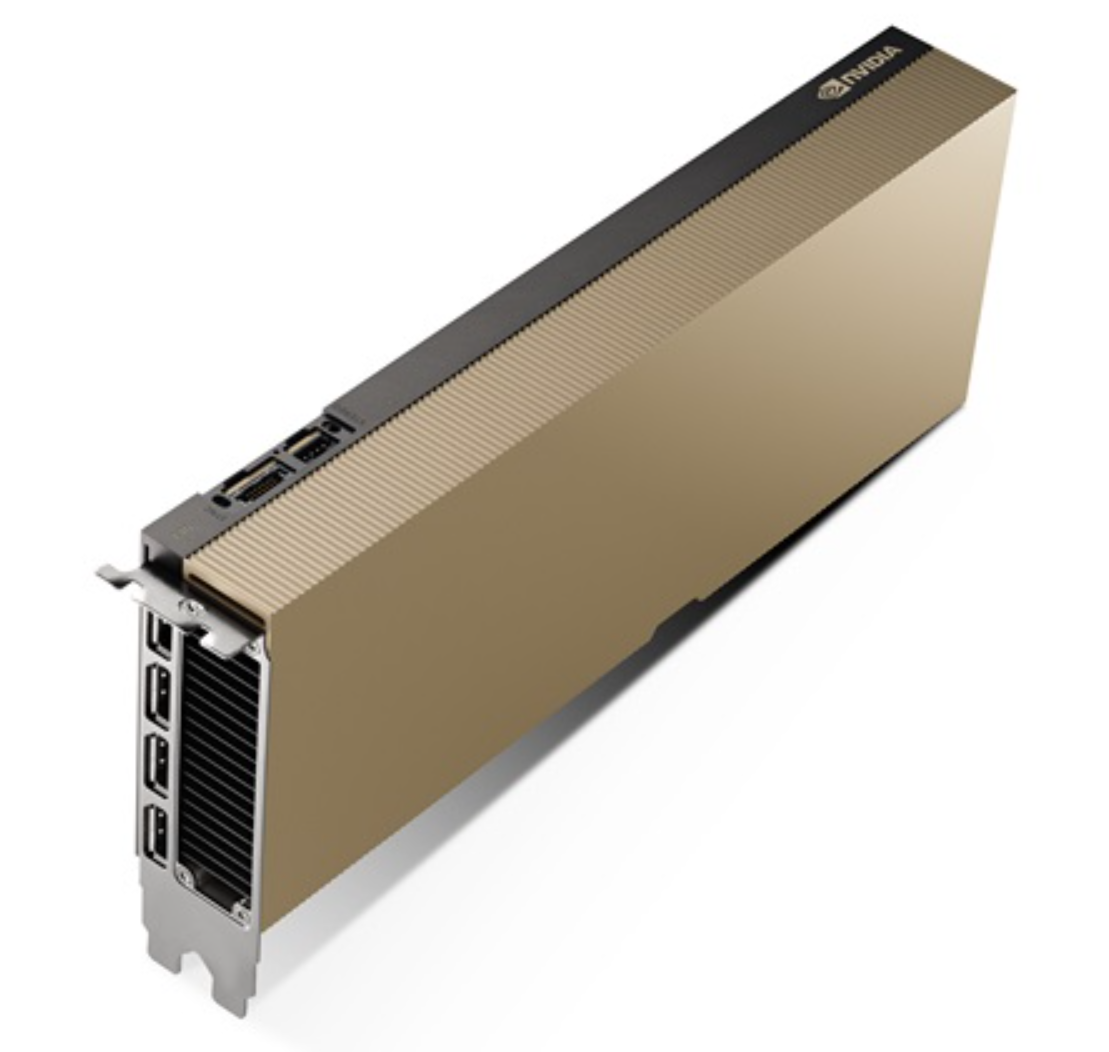

Được đóng gói trong thiết kế khe cắm kép, làm mát thụ động và tiết kiệm điện, L40 có sẵn trong nhiều Hệ thống được chứng nhận NVIDIA™ từ các nhà cung cấp OEM hàng đầu.

→ Chi tiết về thông số kỹ thuật của GPU NVIDIA L40 xem tại đây.

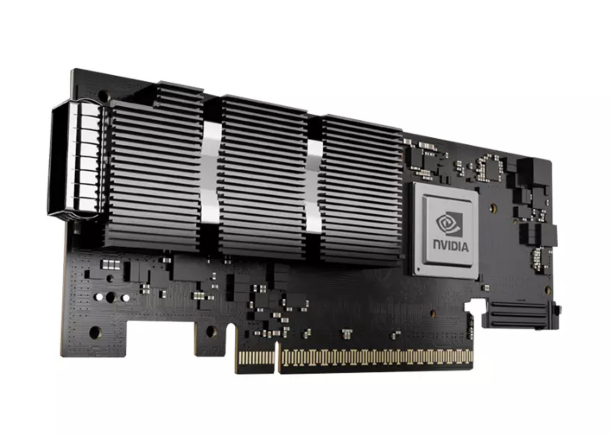

2.4. NVIDIA L4 24GB GPU

NVIDIA L4 Tensor Core GPU là bộ tăng tốc đột phá, đa năng, mang lại hiệu quả vượt trội cho video, AI và đồ họa.

NVIDIA L4 Tensor Core GPU là bộ tăng tốc đột phá, đa năng, mang lại hiệu quả vượt trội cho video, AI và đồ họa.

Dựa trên kiến trúc NVIDIA Ada Lovelace, L4 mang đến khả năng tăng tốc toàn diện và tiết kiệm năng lượng cho các ứng dụng video, AI, máy tính để bàn ảo và đồ họa trong doanh nghiệp, đám mây và biên.

Tối ưu hóa cho suy luận quy mô lớn, L4 hỗ trợ nhiều ứng dụng AI như đề xuất, trợ lý ảo giọng nói, AI tạo sinh, tìm kiếm hình ảnh và tự động hóa trung tâm liên lạc, mang lại trải nghiệm cá nhân hóa tốt nhất.

Là bộ tăng tốc NVIDIA hiệu quả nhất cho sử dụng phổ thông, máy chủ trang bị L4 tăng hiệu suất video AI lên đến 120 lần so với giải pháp CPU, hiệu suất AI tạo sinh gấp 2.5 lần và hiệu suất đồ họa gấp 4 lần so với thế hệ GPU trước.

Tính linh hoạt, thiết kế tiết kiệm năng lượng, khe cắm đơn, cấu hình thấp của NVIDIA L4 lý tưởng cho triển khai toàn cầu, kể cả tại các vị trí biên.

→ Chi tiết về thông số kỹ thuật của GPU NVIDIA L4 xem tại đây.

3. Bộ xử lý trung tâm (CPU)

Mặc dù GPU đóng vai trò chính trong học sâu, CPU vẫn cần thiết để thực hiện các tác vụ quản lý hệ thống, tiền xử lý dữ liệu và các tác vụ AI khác. Các dòng CPU mạnh mẽ như Intel Xeon hoặc AMD EPYC thường được sử dụng.

Mặc dù GPU đóng vai trò chính trong học sâu, CPU vẫn cần thiết để thực hiện các tác vụ quản lý hệ thống, tiền xử lý dữ liệu và các tác vụ AI khác. Các dòng CPU mạnh mẽ như Intel Xeon hoặc AMD EPYC thường được sử dụng.

3.1. CPU Intel

Bộ vi xử lý Intel Xeon Scalable Gen 4 và Gen 5 với, các tên mã là Sapphire Rapids và Emerald Rapids, là các dòng CPU hiệu năng cao dành cho trung tâm dữ liệu, điện toán đám mây, AI/ML và các ứng dụng doanh nghiệp. Với những cải tiến về kiến trúc, khả năng mở rộng và tích hợp nhiều công nghệ tiên tiến, dòng CPU này mang lại hiệu suất vượt trội và tiết kiệm điện năng.

Và với Intel Xeon 6, đây là thế hệ CPU mới nhất dành cho trung tâm dữ liệu, HPC (High-Performance Computing), AI/ML và điện toán đám mây. Được chia thành hai dòng chính là Xeon 6 E-Core (Efficient-Core) và Xeon 6 P-Core (Performance-Core), dòng CPU này mang đến sự tối ưu hóa hiệu suất và điện năng tiêu thụ, giúp doanh nghiệp đạt được hiệu quả tính toán cao nhất.

→ Chi tiết về CPU Intel Xeon cho AI/HPC xem tại đây.

3.2. AMD EYPC CPU

AMD EPYC 9005 series là dòng CPU máy chủ thế hệ thứ 5 của AMD, được thiết kế đặc biệt để đáp ứng nhu cầu ngày càng tăng về hiệu năng tính toán trong các ứng dụng trí tuệ nhân tạo (AI). Với kiến trúc “Zen 5” tiên tiến, số lượng lõi lớn, băng thông bộ nhớ vượt trội và các tính năng bảo mật hàng đầu, EPYC 9005 series mang đến hiệu năng và hiệu quả chưa từng có cho hạ tầng AI.

EPYC 9005 series có khả năng xử lý dữ liệu lớn một cách nhanh chóng và hiệu quả, đáp ứng nhu cầu của các ứng dụng AI đòi hỏi khối lượng dữ liệu khổng lồ.

→ Chi tiết về CPU AMD EPYC cho AI/HPC xem tại đây.

4. Bộ lưu trữ (Storage)

AI đòi hỏi khả năng lưu trữ lượng lớn dữ liệu huấn luyện và mô hình. Các giải pháp lưu trữ hiệu suất cao như ổ cứng thể rắn (SSD) hoặc hệ thống lưu trữ flash là cần thiết để đảm bảo tốc độ truy xuất dữ liệu nhanh chóng. Thiết lập hệ thống lưu trữ và mạng tốc độ cao để đảm bảo truyền dữ liệu hiệu quả.

AI đòi hỏi khả năng lưu trữ lượng lớn dữ liệu huấn luyện và mô hình. Các giải pháp lưu trữ hiệu suất cao như ổ cứng thể rắn (SSD) hoặc hệ thống lưu trữ flash là cần thiết để đảm bảo tốc độ truy xuất dữ liệu nhanh chóng. Thiết lập hệ thống lưu trữ và mạng tốc độ cao để đảm bảo truyền dữ liệu hiệu quả.

Để tối ưu hóa hoạt động của hệ thống lưu trữ và xử lý dữ liệu AI cho doanh nghiệp của bạn hiệu quả hơn, chúng ta nên trang bị các thiết bị lưu trữ hiệu suất cao và được thiết kế riêng cho hạ tầng AI/HPC hiện nay.

Các nhà cung cấp giải pháp lưu trữ hiệu suất cao cho AI:

4.1. VAST Data

VAST Data cung cấp một kiến trúc lưu trữ Universal Storage mang tính cách mạng, giúp giải quyết các hạn chế của hệ thống lưu trữ truyền thống bằng cách kết hợp hiệu suất cao, khả năng mở rộng linh hoạt và chi phí tối ưu. Đây là giải pháp lý tưởng cho các ứng dụng AI, phân tích dữ liệu lớn (Big Data) và HPC (High-Performance Computing).

→ Chi tiết giải pháp lưu trữ hiệu suất cao của VAST xem tại đây.

4.2. DDN (DataDirect Networks)

DDN (DataDirect Networks) là nhà cung cấp hàng đầu về các giải pháp lưu trữ hiệu suất cao dành cho AI, HPC (High-Performance Computing) và phân tích dữ liệu lớn (Big Data Analytics). Với hơn 20 năm kinh nghiệm, DDN cung cấp các hệ thống lưu trữ tối ưu hóa cho khối lượng dữ liệu khổng lồ, đảm bảo tốc độ truy xuất nhanh, khả năng mở rộng linh hoạt và độ tin cậy cao.

→ Chi tiết giải pháp lưu trữ hiệu suất cao của DDN xem tại đây.

4.3. QNAP và INFORTREND: Giải Pháp Lưu Trữ Hiệu Quả Chi Phí Cho Doanh Nghiệp

QNAP và INFORTREND là hai nhà sản xuất hàng đầu trong lĩnh vực lưu trữ dữ liệu, nổi tiếng với các giải pháp NAS (Network Attached Storage) và SAN (Storage Area Network) có hiệu suất tốt và đặc biệt là khả năng tối ưu chi phí đầu tư.

- QNAP: Linh Hoạt và Tiết Kiệm Cho Doanh Nghiệp Nhỏ và Vừa, chi tiết xem tại đây

- INFORTREND: Hiệu Suất và Độ Tin Cậy Với Chi Phí Hợp Lý, chi tiết xem tại đây

5. Kết Nối Mạng (Networking)

Trong kỷ nguyên của trí tuệ nhân tạo (AI), dữ liệu là “vàng”. Để khai thác tối đa tiềm năng của AI, hạ tầng mạng hiệu năng cao là yếu tố then chốt. NVIDIA Networking là một giải pháp mạng hàng đầu, mang lại hiệu năng vượt trội và đáp ứng nhu cầu ngày càng tăng của các ứng dụng AI.

Trong kỷ nguyên của trí tuệ nhân tạo (AI), dữ liệu là “vàng”. Để khai thác tối đa tiềm năng của AI, hạ tầng mạng hiệu năng cao là yếu tố then chốt. NVIDIA Networking là một giải pháp mạng hàng đầu, mang lại hiệu năng vượt trội và đáp ứng nhu cầu ngày càng tăng của các ứng dụng AI.

Thiết bị mạng NVIDIA Networking, bao gồm các sản phẩm như NVIDIA Spectrum Ethernet Switches, NVIDIA Quantum InfiniBand Switches, NVIDIA ConnectX NICs, đã trở thành một trong những giải pháp hàng đầu giúp tăng tốc hạ tầng AI

5.1. NVIDIA InfiniBand – Hệ thống mạng tốc độ cao cho AI và HPC

NVIDIA Quantum InfiniBand cung cấp băng thông lên đến 400Gb/s, hỗ trợ RDMA (Remote Direct Memory Access) và NVIDIA GPUDirect RDMA.

5.2.NVIDIA Spectrum – Switch Ethernet Hiệu Suất Cao Cho AI

NVIDIA Spectrum Ethernet Switches hỗ trợ tốc độ từ 200Gb/s đến 800Gb/s, với khả năng xử lý AI workload nhanh chóng, hỗ trợ RoCE v2.

5.3.NVIDIA ConnectX – Card Mạng Tốc Độ Cao Cho AI

NVIDIA ConnectX-7/8 là dòng NIC (Network Interface Card) hàng đầu cho AI, với tốc độ 400Gb/s, hỗ trợ GPUDirect RDMA và PTP (Precision Time Protocol).

→ Chi tiết các sản phẩm và giải pháp Networking tốc độ siêu cao cho AI/HPC của NVIDIA xem tại đây.

6. Thiết bị phụ trợ

Ngoài ra, cần có các thiết bị hỗ trợ khác như hệ thống làm mát, nguồn điện dự phòng và thiết bị bảo mật để đảm bảo hoạt động ổn định và an toàn của hạ tầng AI.

NTC Enterprise AI Server: Hệ thống AI chuyên dụng cho kỷ nguyên đổi mới

Là đối tác cấp độ Elite của NVIDIA, Nhất Tiến Chung có thể cung cấp toàn diện các giải pháp AI chuyên dụng, bao gồm các GPU (H200 NVL, H100 NVL, L40s, L40, L4), hệ thống AI Server, giải pháp lưu trữ hiệu suất cao (VAST, DDN, QNAP, Infortrend), và phần mềm (NVIDIA Base Command, NVIDIA AI Enterprise).

Bên cạnh đó, với kinh nghiệm triển khai hạ tầng AI của mình, Nhất Tiến Chung luôn sẵn sàng trong việc hỗ trợ các doanh nghiệp từ tư vấn, xây dựng hệ thống, cho đến triển khai lắp đặt và vận hành một hệ thống AI tối ưu nhất cho công ty của bạn.

| GPU SuperServer SYS-422GL-NR | Asus GPU Server ESC8000-E11 | GPU SuperServer SYS-421GE-TNRT | Máy chủ HPE ProLiant DL380 Gen11 (2U SFF - 8 x 2.5") | Máy chủ HPE ProLiant DL360 Gen11 (1U SFF - 8 x 2.5") | |

|

|

|

|

|

|

| Giá tham khảo | Liên hệ | 256.500.000 VNĐ | Liên hệ | 102.600.000 VNĐ | 99.900.000 VNĐ |

| Mã hàng | GPU SuperServer SYS-422GL-NR | ESC8000-E11 | GPU SuperServer SYS-421GE-TNRT | Máy chủ HPE ProLiant DL380 Gen11 | Máy chủ HPE ProLiant DL360 Gen11 |

| Thương hiệu | Supermicro | Asus | Supermicro | HPE | HPE |

| GPU Support | Up to 8 x GPU NVIDIA H200 NVL / L40S | Up to 8 x GPU NVIDIA H100 NVL; L40s; L40 | Up to 10 x GPU NVIDIA L40s / L40 / L4 | None | None |

| Storage | 8 front hot-swap E1.S NVMe drive bays | 8 x 3.5'' Front Hot-swap Storage Bays (backplane supports up to 8 x NVMe/SATA/SAS*) | Total 24 bays: 8 front hot-swap 2.5" NVMe drive bays; 8 front hot-swap 2.5" NVMe* drive bays; 8 front hot-swap 2.5" SATA drive bays | 8, 16, or 24 SFF SAS/SATA/SSD | 4 LFF or 8 SFF SAS/SATA/SSD |

Email: sales@nhattienchung.vn