Trí tuệ nhân tạo (AI) – Động lực cách mạng trong mọi ngành công nghiệp

AI đang trở thành nền tảng cốt lõi thúc đẩy sự đổi mới trong mọi lĩnh vực, từ chăm sóc sức khỏe, sản xuất cho đến tài chính. Các ứng dụng AI trong doanh nghiệp không ngừng mở rộng, bao gồm mô hình ngôn ngữ, an ninh mạng, hệ thống tự trị và y tế.

Tuy nhiên, sự phát triển nhanh chóng của AI không chỉ dừng lại ở số lượng ứng dụng mà còn ở độ phức tạp của mô hình và dữ liệu. Việc xử lý, đào tạo và triển khai các mô hình thế hệ mới đòi hỏi một hạ tầng tính toán mạnh mẽ, có khả năng mở rộng.

Các mô hình AI hiện đại yêu cầu hàng chục đến hàng trăm GPU để đánh giá, tối ưu hóa và đào tạo trên lượng dữ liệu khổng lồ. Đồng thời, trong các tổ chức có nhiều nhóm nghiên cứu AI, nhu cầu đào tạo đồng thời nhiều mô hình đặt ra bài toán về quản lý tài nguyên hiệu quả, đảm bảo sự linh hoạt cho các nhà phát triển và nhà nghiên cứu.

AI Factory – Hạ tầng AI thế hệ mới

AI Factory là một hệ sinh thái toàn diện, kết hợp phần cứng hiệu suất cao, phần mềm tối ưu và dịch vụ chuyên nghiệp, giúp doanh nghiệp xây dựng, triển khai và vận hành các ứng dụng AI một cách hiệu quả trong toàn bộ vòng đời. Không đơn thuần là một trung tâm dữ liệu, AI Factory hoạt động như một nhà máy sản xuất trí thông minh – nơi dữ liệu thô được xử lý, tinh chỉnh để tạo ra những mô hình AI giá trị.

Lợi ích của AI Factory

- Tăng tốc phát triển AI – Hạ tầng GPU mạnh mẽ giúp rút ngắn thời gian đào tạo mô hình, đẩy nhanh quá trình đưa sản phẩm AI ra thị trường.

- Tối ưu hiệu suất – Hệ thống được thiết kế tối ưu cho AI, từ đào tạo đến suy luận, đảm bảo khai thác tối đa sức mạnh phần cứng.

- Đơn giản hóa triển khai – Bộ công cụ và dịch vụ hỗ trợ giúp dễ dàng triển khai AI từ trung tâm dữ liệu, đám mây đến thiết bị biên.

- Tối ưu chi phí – Giảm thiểu chi phí đầu tư và vận hành nhờ hiệu suất cao và quản lý tài nguyên thông minh.

- Nâng cao năng lực cạnh tranh – Doanh nghiệp có thể tận dụng AI để phát triển sản phẩm, dịch vụ đột phá, dẫn đầu thị trường.

- AI có chủ quyền – Xây dựng AI Factory trong nước giúp các quốc gia tự chủ trong phát triển AI, tạo ra các mô hình phù hợp với dữ liệu và nhu cầu địa phương.

AI Factory không chỉ là giải pháp hạ tầng, mà còn là bước tiến chiến lược giúp doanh nghiệp và quốc gia khai thác tối đa tiềm năng của AI, mở ra kỷ nguyên trí tuệ nhân tạo đầy đột phá.

Cách thức triển khai hệ thống AI Factory

Việc triển khai một hệ thống AI Factory đòi hỏi sự kết hợp giữa phần cứng, phần mềm và dịch vụ. Dưới đây là các bước cơ bản.

Lựa chọn phần cứng

GPU: Lựa chọn các GPU phù hợp với nhu cầu tính toán, từ NVIDIA B200 và H200 cho các tác vụ đào tạo mô hình lớn, đến các GPU L40s và L4 cho suy luận.

Hệ thống máy chủ: Xây dựng hệ thống máy chủ mạnh mẽ, đảm bảo khả năng mở rộng và hiệu suất cao.

Hệ thống lưu trữ và mạng: Thiết lập hệ thống lưu trữ và mạng tốc độ cao để đảm bảo truyền dữ liệu hiệu quả.

Cài đặt phần mềm

NVIDIA AI Enterprise: Cài đặt bộ phần mềm NVIDIA AI Enterprise, bao gồm các công cụ và thư viện tối ưu hóa cho AI.

NVIDIA NGC: Sử dụng nền tảng NVIDIA NGC để truy cập các container và mô hình AI được tối ưu hóa.

Phần mềm của các đối tác NVIDIA.

Triển khai dịch vụ

NVIDIA Professional Services: Sử dụng dịch vụ chuyên nghiệp của NVIDIA để được hỗ trợ trong quá trình triển khai và tối ưu hóa hệ thống.

Hợp tác với các đối tác của NVIDIA để nhận được sự hỗ trợ tốt nhất.

Đào tạo và vận hành

Đào tạo đội ngũ nhân viên về các công nghệ AI và cách vận hành hệ thống AI Factory.

Thiết lập quy trình vận hành và bảo trì hệ thống để đảm bảo hoạt động liên tục và hiệu quả.

Để triển khai một hệ thống AI Factory tối ưu, Đội ngũ NTC đã dựa trên nền tảng NVIDIA DGX BasePod™, một giải pháp hạ tầng tích hợp, giúp doanh nghiệp rút ngắn thời gian triển khai và đơn giản hóa quản lý AI.

Tổng quan về NVIDIA DGX BasePod™

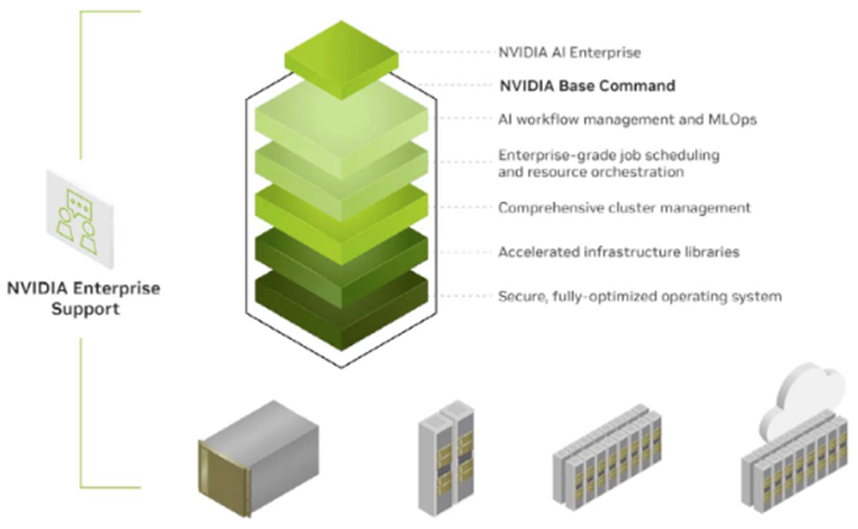

NVIDIA DGX BasePod™ là nền tảng hạ tầng AI tiên tiến, kết hợp phần cứng mạnh mẽ, phần mềm tối ưu và các công cụ MLOps, giúp tăng tốc quá trình phát triển và vận hành AI. Được xây dựng dựa trên thành công của NVIDIA DGX Systems, DGX BasePod loại bỏ những thách thức về thiết kế, chu kỳ triển khai dài và sự phức tạp trong quản lý hạ tầng AI truyền thống. Giải pháp này được hỗ trợ bởi NVIDIA Base Command™, mang đến nền tảng AI linh hoạt và hiệu suất cao dành cho doanh nghiệp.

DGX BasePod™ là một kiến trúc tham chiếu (RA – Reference Architecture) tích hợp các thành phần phần cứng, phần mềm của NVIDIA cùng với các giải pháp MLOps và lưu trữ từ các đối tác hàng đầu. Kiến trúc này cho phép doanh nghiệp triển khai hệ thống từ hai nút đến hàng chục nút, kết hợp với các giải pháp lưu trữ được chứng nhận, giúp đơn giản hóa việc quản lý CNTT và tối ưu hóa tài nguyên hạ tầng.

Các giải pháp MLOps tùy chọn cũng có thể được tích hợp để tạo ra một hệ sinh thái AI hoàn chỉnh, giúp rút ngắn chu kỳ phát triển mô hình và tối ưu ROI (Return on Investment) cho các sáng kiến AI.

Ưu điểm nổi bật của NVIDIA DGX BasePod™

- Tăng tốc triển khai AI – Loại bỏ các rào cản về thiết kế, giúp doanh nghiệp nhanh chóng đưa AI vào sản xuất.

- Đơn giản hóa quản lý – Cấu trúc hạ tầng theo quy định, giúp quản lý hệ thống AI dễ dàng và hiệu quả hơn.

- Tối ưu hiệu suất – Sử dụng GPU NVIDIA DGX mạnh mẽ, kết hợp với phần mềm NVIDIA Base Command™ để đảm bảo hiệu suất cao nhất.

- Mở rộng linh hoạt – Dễ dàng mở rộng từ quy mô nhỏ đến lớn với các nền tảng lưu trữ và MLOps tiên tiến.

- Rút ngắn chu kỳ phát triển mô hình AI – Hỗ trợ MLOps giúp tối ưu hóa quy trình AI, giảm thời gian từ nghiên cứu đến triển khai thực tế.

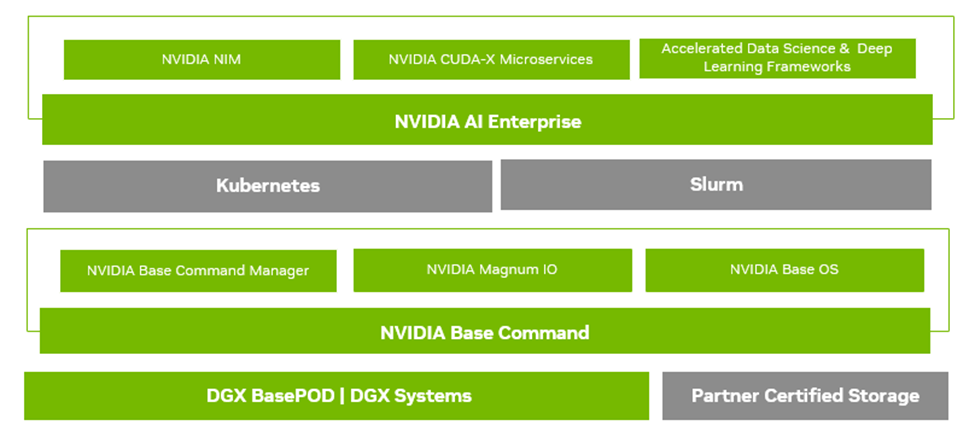

Hình dưới đây là các thành phần chính của NVIDIA DGX BasePod™. Mỗi lớp trong kiến trúc này là một điểm tích hợp quan trọng mà doanh nghiệp thường phải tự xây dựng và tinh chỉnh trước khi triển khai AI. Với DGX BasePod, chúng sẽ giúp đơn giản hóa quá trình này, đảm bảo khả năng mở rộng và tối ưu hóa hiệu suất AI một cách hiệu quả nhất.

Hãy cùng tổng quan về những thành phần chính có trong hệ thống DGX BasePod:

NVIDIA Networking

Infiniband và Ethernet Technologies cho phép chức năng kết nối mạng trong DGX Basepod. Mạng thích hợp là rất quan trọng để đảm bảo rằng DGX Basepod không có bất kỳ tắc nghẽn nào hoặc bị suy giảm hiệu suất cho khối lượng công việc AI.

Thiết bị lưu trữ hiệu suất cao

DGX BasePod được xây dựng trên một hệ sinh thái công nghệ lưu trữ đã được chứng minh. Khi NVIDIA xác nhận các đối tác lưu trữ giới thiệu các công nghệ lưu trữ mới vào thị trường, họ sẽ đủ điều kiện các dịch vụ mới này với DGX Basepod để đảm bảo khả năng tương thích thiết kế và hiệu suất dự kiếncho khối lượng công việc đã biết. Mỗi đối tác lưu trữ đã thực hiện thử nghiệm nghiêm ngặt để đảm bảo các ứng dụng nhận được hiệu suất và thông lượng cao nhất khi được triển khai với DGX Basepod.

Phần mềm NVIDIA

Lệnh cơ sở NVIDIA

Lệnh cơ sở NVIDIA cung cấp sức mạnh cho mọi DGX Basepod, cho phép các tổ chức tận dụng sự đổi mới phần mềm tốt nhất của NVIDIA.

Phần cứng DGX BasePod được tối ưu hóa hơn nữa với các thư viện gia tốc để biết cách tối đa hóa hiệu suất của khối lượng công việc AI trên GPU, hệ thống DGX và toàn bộ cụm DGX, truy cập dữ liệu, chuyển động và quản lý tăng tốc từ hệ thống I/O đến lưu trữ đến kết nối mạng.

Base Command cung cấp quản lý cụm tích hợp từ cài đặt và cung cấp để giám sát các hệ thống liên tục từ một đến hàng trăm hệ thống DGX. Lệnh cơ sở cũng hỗ trợ nhiều phương pháp để quản lý quy trình công việc. Slurm hoặc Kubernetes có thể được sử dụng để cho phép lập lịch và quản lý các tài nguyên hệ thống tối ưu trong môi trường nhiều người dùng.

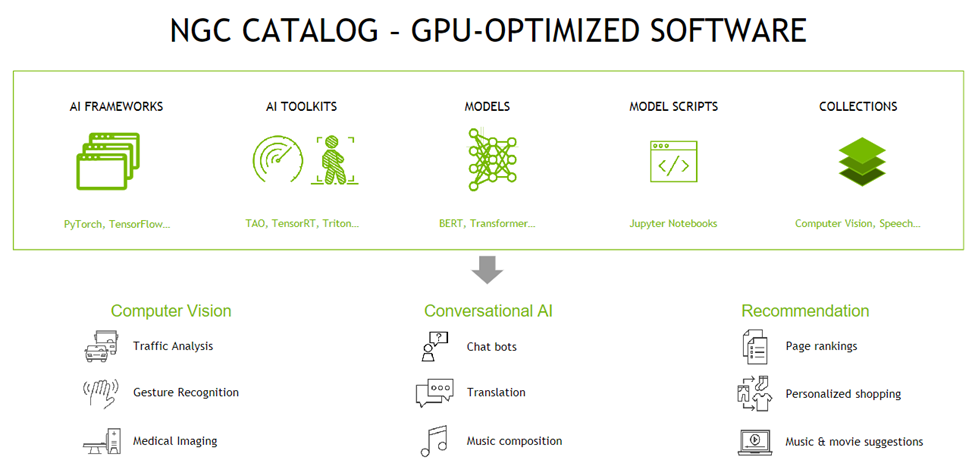

NVIDIA NGC

NVIDIA NGC cung cấp phần mềm để đáp ứng nhu cầu của các nhà khoa học, nhà phát triển và nhà nghiên cứu dữ liệu với các cấp độ chuyên môn AI khác nhau.

Phần mềm được lưu trữ trên NGC trải qua các lần quét chống lại một tập hợp các lỗ hổng, tiền điện tử và khóa riêng. Nó được thử nghiệm và thiết kế để mở rộng quy mô thành nhiều GPU và trong nhiều trường hợp, với nhiều nút, đảm bảo người dùng tối đa hóa khoản đầu tư của họ vào các hệ thống DGX.

NVIDIA AI Enterprise

NVIDIA AI Enterprise là nền tảng phần mềm từ đầu đến cuối, đưa AI đến mọi doanh nghiệp, cung cấp thời gian chạy nhanh nhất và hiệu quả nhất cho các mô hình AI Foundation phát triển được phát triển với nền tảng NVIDIA DGX. Với bảo mật cấp độ sản xuất, tính ổn định và khả năng quản lý, nó hợp lý hóa sự phát triển của các giải pháp AI tổng quát.

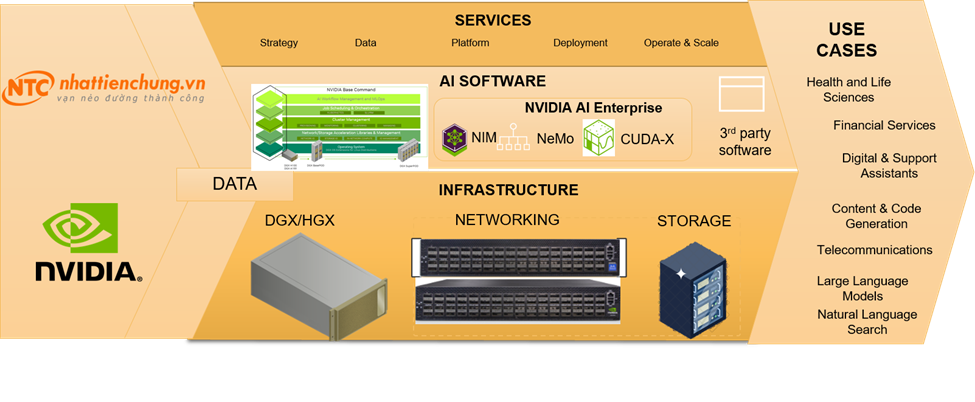

Các thành phần cốt lõi của AI Factory

Một hệ thống AI Factory hoàn chỉnh dựa trên nền tảng DGX BasePOD sẽ bao gồm các thành phần cốt lõi sau:

– Siêu máy tính NVIDIA DGX

– Các thiết bị mạng tốc độ cao NVIDIA Networking

– Các thiết bị lưu trữ hiệu suất cao, độ trễ cực thấp

– Phần mềm nền tảng dành cho AI

Hệ thống NVIDIA DGX

Cấu hình Basepod của NVIDIA DGX sử dụng các hệ thống DGX B200, DGX H200 và H100. Các hệ thống siêu máy tính là thành phần tính toán, phân tích dữ liệu lớn với sức mạnh khổng lồ từ các GPU.

NVIDIA DGX B200

Hệ thống NVIDIA DGX B200 cung cấp mật độ, hiệu suất và tính linh hoạt chưa từng có.

Thông số kỹ thuật NVIDIA DGX B200

- 8x NVIDIA B200 GPU

- 1.4TB of GPU memory space

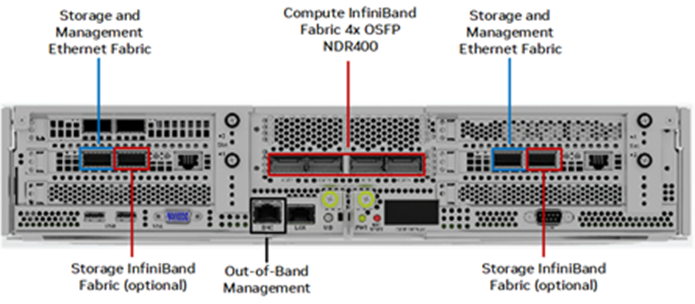

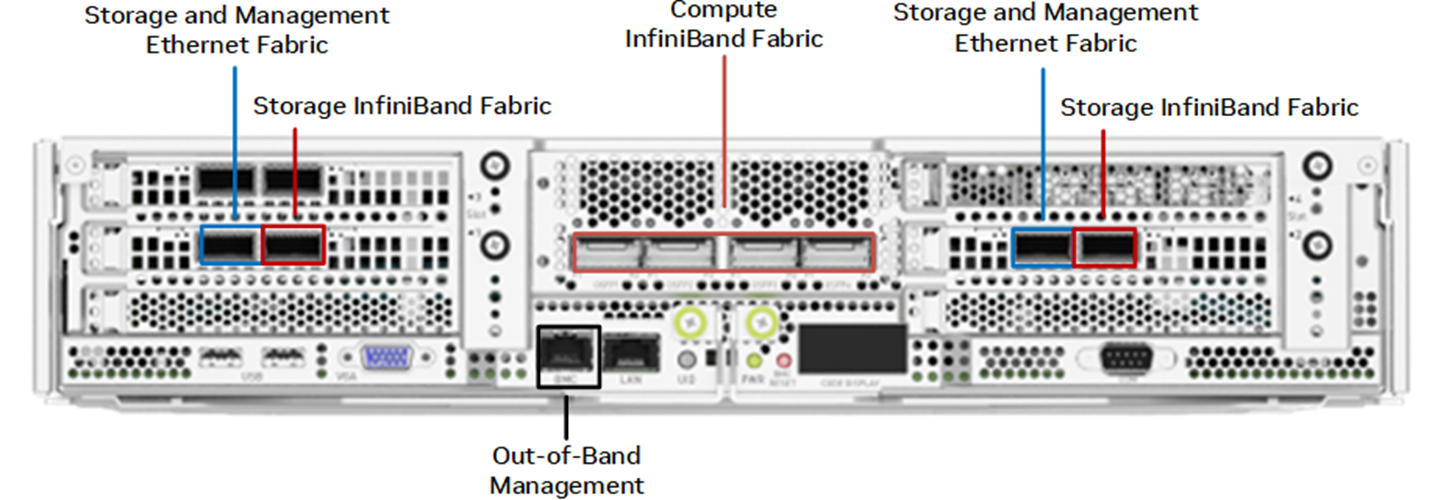

- 4x OSFP ports serving 8x single-port NVIDIA ConnectX-7 VPI

- Up to 400Gb/s InfiniBand/Ethernet 2x dual-port QSFP112 NVIDIA BlueField-3 DPU

- Dual 5th generation Intel® Xeon® Scalable Processors

NVIDIA DGX H200 và H100

DGX H200 là cỗ máy trí tuệ nhân tạo với hiệu suất đột phá dựa trên kiến trúc NVIDIA Hopper.

Thông số kỹ thuật NVIDIA DGX H200 và DGX H100

- Eight NVIDIA Hopper GPUs.

- 1,128 GB total GPU memory for H200.

- 640 GB total GPU memory for H100.

- Four NVIDIA NVSwitch™ chips.

- Dual Intel® Xeon® Platinum 8480C processors, 112 cores total, 2.00 GHz (Base), 3.80 GHz (Max Boost) with PCIe 5.0 support.

- 2 TB of DDR5 system memory.

- Four OSFP ports serving eight single-port NVIDIA ConnectX-7 VPI, 2x dual-port QSFP112 NVIDIA ConnectX-7 VPI, up to 400 Gb/s InfiniBand/Ethernet.

- 10Gb/s onboard NIC with RJ45, 100 Gb/s Ethernet NIC, BMC with RJ45.

- Two 1.92 TB M.2 NVMe drives for DGX OS, eight 3.84 TB U.2 NVMe drives for storage/cache.

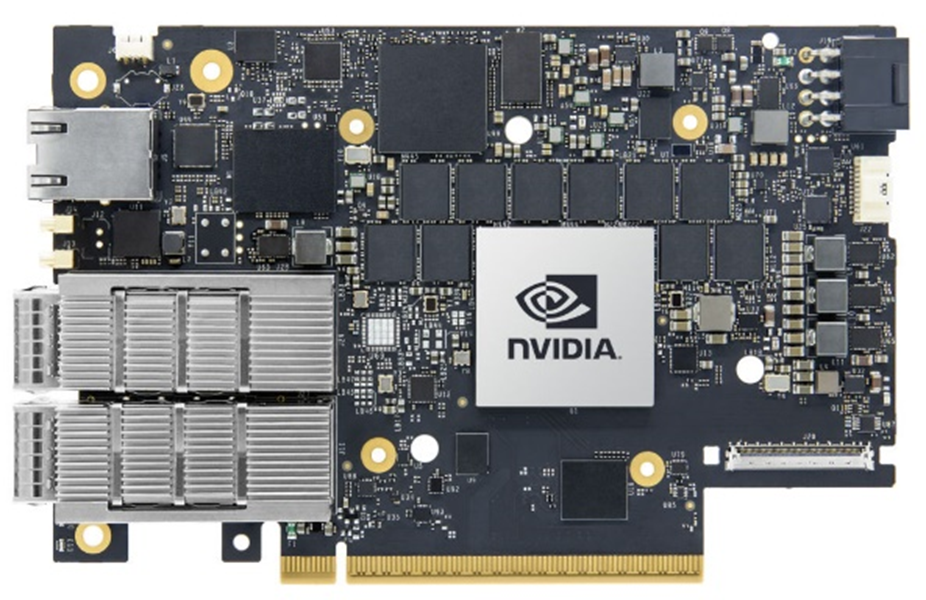

Bộ điều hợp mạng NVIDIA

NVIDIA DGX B200 và DGX H200 và H100 được trang bị các bộ điều hợp mạng NVIDIA® ConnectX®-7. DGX B200 có cả bộ điều hợp mạng ConnectX-7 và Nvidia Bluefield-3. Các bộ điều hợp mạng được mô tả trong phần này.

Bộ điều hợp VPI ConnectX-7 (Hình 8) là dòng bộ điều hợp kết nối mới nhất. Nó có thể cung cấp thông lượng 25/50/100/200/400g. Hệ thống NVIDIA DGX Sử dụng HCA ConnectX-7 và Bluefield-3 (chế độ NIC) để cung cấp tính linh hoạt trong triển khai DGX Basepod với NDR400 và ROCE.

Bộ chuyển mạch NVIDIA

Cấu hình DGX BasePod có thể được trang bị bốn loại bộ chuyển mạch (switch) NVIDIA với các chứng năng kết nối giữa các thành phần tính toán, lưu trữ và quản trị hệ thống cho DGX BasePOD

NVIDIA QM9700 Switch

Các công tắc NVIDIA QM9700 (Hình 10) với NDR Infiniband kết nối năng lượng Vải tính trong cấu hình NDR Basepod. Bộ điều hợp một cổng kết nối được sử dụng cho vải tính toán infiniband. Mỗi hệ thống NVIDIA DGX có các kết nối kép với mỗi công tắc QM9700, cung cấp nhiều đường dẫn âm thanh cao, băng thông thấp giữa các hệ thống.

NVIDIA SN4600C Switch

Các công tắc NVIDIA SN4600C (Hình 11) cung cấp 128 tổng số cổng (64 mỗi công tắc) để cung cấp kết nối dự phòng để quản lý trong băng tần của DGX Basepod. Công tắc NVIDIA SN4600C có thể cung cấp tốc độ từ 1 GBE đến 100 GBE.

Đối với các thiết bị lưu trữ được kết nối qua Ethernet, các công tắc NVIDIA SN4600 cũng được sử dụng. Các cổng trên các bộ điều hợp mạng cổng kép NVIDIA DGX được sử dụng cho cả kết nối lưu trữ và quản lý trong băng tần.

NVIDIA SN2201 Switch

Các công tắc NVIDIA SN2201 (Hình 12) cung cấp 48 cổng để cung cấp kết nối cho quản lý OOB. OOB Management cung cấp kết nối quản lý hợp nhất cho tất cả các thành phần trong BasePod.

Control Plane

Bao gồm trong hệ thống là 5 máy chủ x86 dual-socket để quản lý hệ thống. Hai nút được sử dụng làm nút đầu cho Base Command Manager. Ba nút bổ sung cung cấp nền tảng để chứa các dịch vụ cụ thể cho việc triển khai.

Yêu cầu tối thiểu đối với mỗi máy chủ là:

2 × Intel x86 Xeon Gold or better

512 GB memory

1 × 6.4 TB NVMe for storage

2 × 480 GB M.2 RAID for OS

4 × 200 Gbps network

2 × 100 GbE network

Triển khai hạ tầng AI Factory cho doanh nghiệp tại Việt Nam

Vơi vai trò là đối tác cấp độ Elite cao nhất của NVIDIA tại Việt Nam, Nhất Tiến Chung đồng hành cùng NVIDIA để giúp khách hàng lựa chọn và triển khai hệ thống AI Factory phù hợp với quy mô đầu tư của bạn.

Với kinh nghiệm và khả năng triển khai hạ tầng AI của đội ngũ Nhất Tiến Chung, chúng tôi sẽ cung cấp đầy đủ cho các doanh nghiệp cả về hạ tầng phần cứng gồm: NVIDIA DGX System, NVIDIA Networking, AI Storage, đến các phần mềm nền tảng như NVIDIA Base Command, NVIDIA AI Enterprise, đặc biệt là dịch vụ về lắp đặt, triển khai và vận hành hệ thống AI Factory cho các doanh nghiệp hiện nay tại Việt Nam.

Tổng quan các thành phần của AI Factory dựa trên nền tảng NVIDIA DGX sẽ bao gồm:

1/ Hạ tầng phần cứng:

– NVIDIA DGX

– NVIDIA HGX (OEM Partner: Supermicro, ASUS, DELL, HPE…)

– NVIDIA NETWORKING

– NVIDIA PARTNER AI STORAGE: DDN, VAST, IBM

2/ AI PLATFORM/SOFTRWARE:

– NVIDIA BASE COMMAND

– NVIDIA AI ENTERPRISE

– NVIDIA NGC

3/ AI SERVICES

4/ USE CASES

Việc tùy chọn một hạ tầng AI Factory dành cho doanh nghiệp của còn còn phụ thuộc vào nhiều yếu tố, từ hạ tầng tính toán, hạ tầng mạng, đến quy mô đào tạo các mô hình dữ liệu, ứng dụng AI mà bạn đang cần xây dựng, cho đến mật độ dữ liệu cần đào tạo, suy luận và phân tích…

Dưới đây là các hạ tầng AI Factory mẫu được đội ngũ Nhất Tiến Chung xây dựng, dựa trên các mức độ triển khai AI Factory khác nhau cho từng doanh nghiệp:

| Component | Technology |

| Compute nodes (2-16) | NVIDIA DGX B200 system with eight 180 GB B200 GPUs, NDR400 InfiniBand networking and two NVIDIA BlueField-3 DPUs

Or NVIDIA DGX H100 system with eight 80 GB H100 GPUs, NDR400 InfiniBand networking, and two NVIDIA ConnectX-7 NICs Or NVIDIA DGX H200 system with eight 141 GB H100 GPUs, NDR400 InfiniBand networking, and two NVIDIA ConnectX-7 NICs |

| Compute fabric | NVIDIA Quantum QM9700 NDR400 Gbps InfiniBand switch |

| Management and storage fabric | NVIDIA SN4600C switches |

| OOB management fabric | NVIDIA SN2201 switches |

| Control plane | Rackmount Servers |

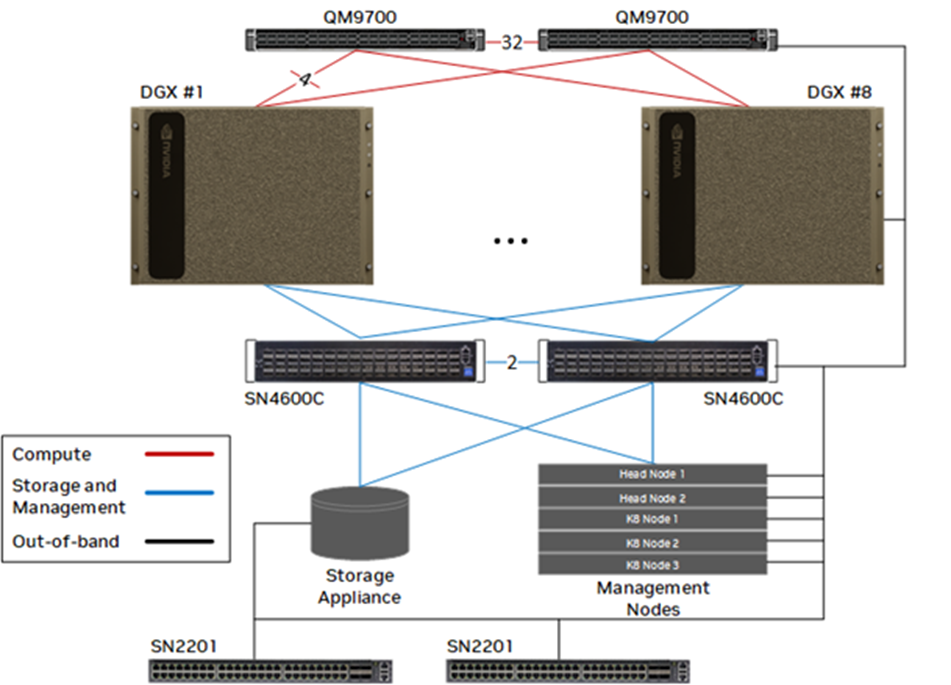

Cấu trúc mạng của hệ thống AI Factory

Cấu trúc mạng cho một hệ thống AI Factory với tối đa 8 nodes DGX B200, H200 hoặc H100 sử dụng tám kết nối từ mỗi nút compute chạy tại NDR400.

Kiến trúc hoàn chỉnh có ba loại mạng: Compute network dựa trên Infiniband, Ethernet network để quản lý, lưu trữ hệ thống và Management Network OOB.

Bao gồm trong kiến trúc tham chiếu là năm máy chủ x86 ổ cắm kép để quản lý hệ thống. Hai nút được sử dụng làm nút đầu cho Trình quản lý lệnh cơ sở. Ba nút bổ sung cung cấp nền tảng để chứa các dịch vụ cụ thể để triển khai. Đây có thể là các nút đăng nhập để triển khai dựa trên SLURM hoặc Kubernetes cho các giải pháp đối tác dựa trên MLOPS.

Bất kỳ máy chủ OEM nào đáp ứng các yêu cầu tối thiểu cho mỗi nút được mô tả trong Bảng 5 đều có thể được sử dụng. Tất cả các máy chủ quản lý được cấu hình trong cặp (HA) (hoặc ba) có tính khả dụng cao (HA), một nút thất bại của một nút đã giành được dẫn đến sự cố mất điện của dịch vụ BasePod.

Tóm tắt

AI Factory là một giải pháp toàn diện giúp doanh nghiệp dễ dàng triển khai và mở rộng các ứng dụng AI với hiệu suất cao. Việc kết hợp phần cứng GPU mạnh mẽ, phần mềm tối ưu hóa và các công cụ quản lý thông minh giúp rút ngắn thời gian phát triển, giảm chi phí và nâng cao hiệu quả vận hành AI.

Đối với các tổ chức đang tìm kiếm giải pháp AI mạnh mẽ, đội ngũ Nhất Tiến Chung của chúng tôi sẵn sàng đồng hành cùng doanh nghiệp của bạn trong việc thiết kế, xây dựng, triển khai, vận hành một AI Factory nhanh chóng, hiệu quả và phù hợp với quy mô của mọi doanh nghiệp.